字节跳动发布开源多模态模型 Mini-o3

字节跳动近日推出开源多模态模型 mini-o3,该模型通过增强推理模式和交互轮次,在视觉搜索任务中实现了在复杂场景下的显著性能提升。

https://www.php.cn/link/837e868ffbb3a67451e480e1864e071d

Mini-o3 是一款完全开源的多模态模型,专为“边看边思考”类型的视觉搜索任务打造。借助强化学习技术,模型可将工具调用扩展至数十轮交互,在多个权威评测基准——包括 VisualProbe、V* Bench、HR-Bench 和 MME-Realworld 上,取得了当前 7B 规模模型中的领先表现。

项目团队公开了完整的训练代码、模型权重,以及一个包含 4,500 条样本的 Visual Probe 数据集,允许研究者在非商业用途下复现类似 OpenAI o3 的深度推理行为。

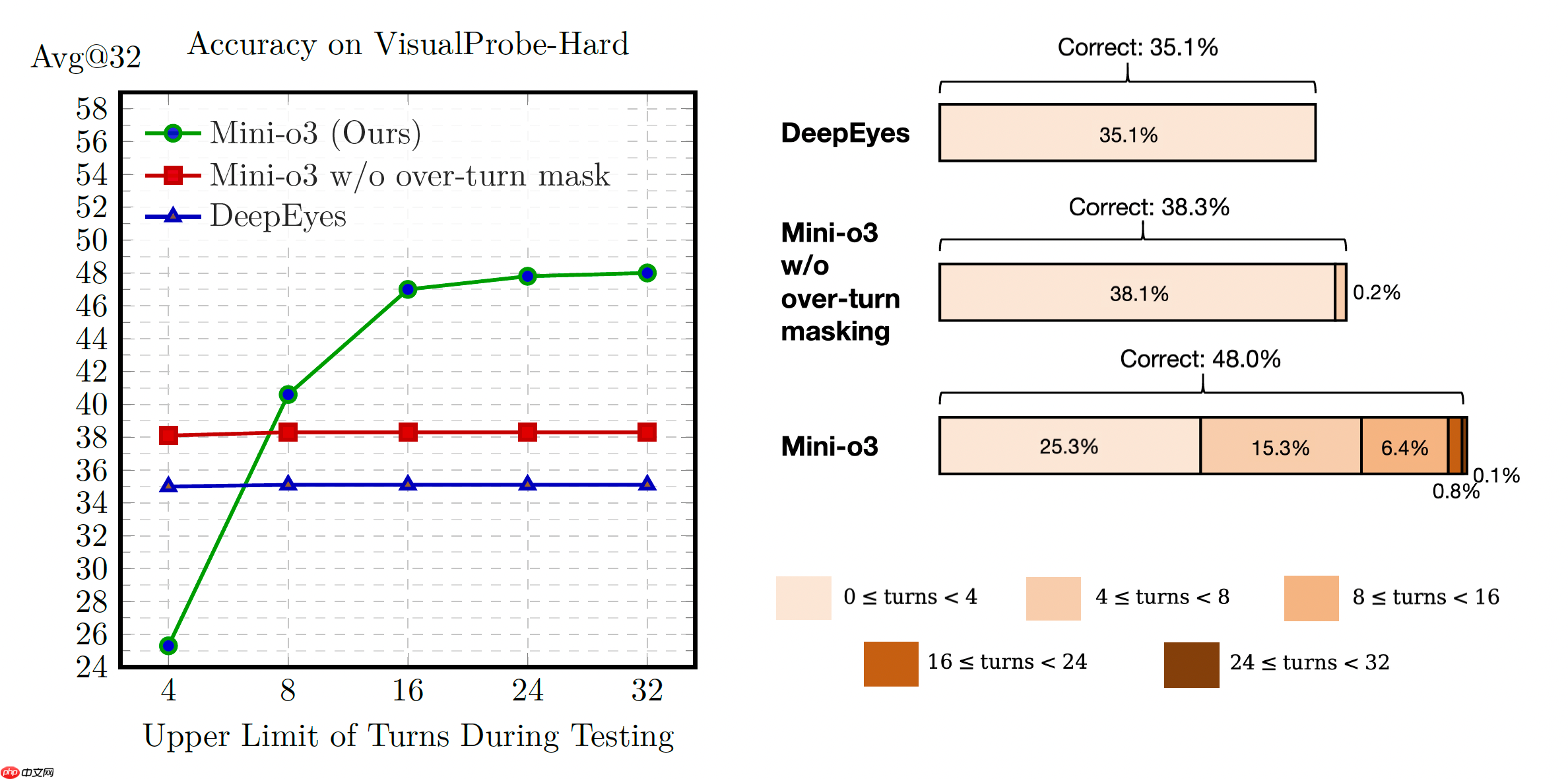

Mini-o3 支持深度优先搜索、试错探索等多种推理策略,测试阶段可将交互轮次扩展至 32 轮以上。随着交互次数增加,准确率明显上升——例如在 VisualProbe-Hard 任务中,准确率从初始的 35.1% 提升至 48.0%。

核心亮点

- 高挑战性数据构建:发布 VisualProbe 数据集,涵盖高分辨率图像、微小目标物体及密集干扰项,迫使模型进行多轮视觉探索。

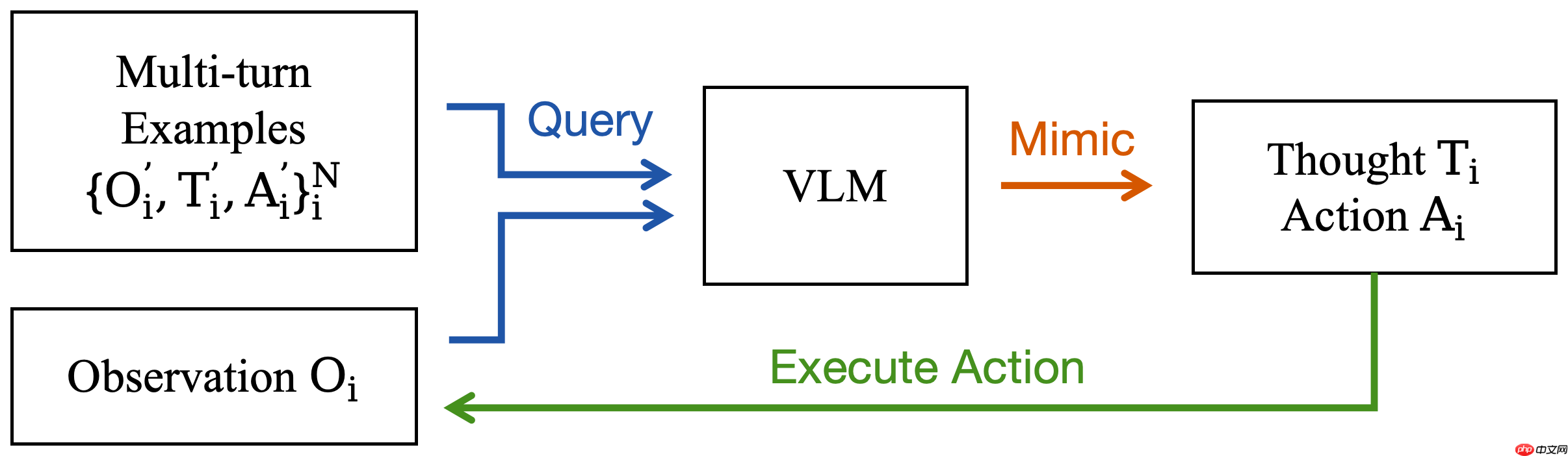

- 迭代式数据采集:采用冷启动方式生成多样化的推理路径,覆盖回溯调整、假设验证等高级策略,弥补预训练模型在多轮交互上的能力短板。

- Over-Turn Masking 机制:在强化学习训练中引入此策略,避免对超出预设轮次的响应进行惩罚,从而鼓励更深层次的探索行为。训练时设定最大轮次为 6,测试时可灵活扩展至 32 轮以上。

应用场景示例

<< 上一篇

下一篇 >>

网友留言(0 条)